Benötigte Lesezeit: 8 Minuten

- Was ist künstliche Intelligenz?

- Der Unterschied zwischen KI, maschinellem Lernen und Deep Learning

- Wie Transformer Modelle die Content-Welt im Sturm erobern

- M6 – Die Zukunft der Transformatoren?

- Was bedeuten diese Entwicklungen für Content Experten?

Als Content-Expertin beobachte ich seit Jahren den Einfluss von Big Data auf Content. 2016 bemerkte ich zum ersten Mal signifikante Veränderungen und den wachsenden Einfluss von KI auf den Nutzer.

Maschinelle Übersetzungen funktionierten plötzlich nahezu fehlerfrei. Eltern erzählten, dass Sprachassistenten die Hausaufgaben für ihre Kinder erledigten, indem sie Antworten auf einfache Fragen lieferten. Instagram-Schönheiten wurden mit Hilfe von KI-unterstützten Face-Tuning-Apps noch schöner. Deepfakes von Obama oder anderen VIPs fluteten und begeisterten das Internet.

Im Redaktionsalltag stellten Schreibassistenten grammatikalisch einwandfreie Texte sicher, smarte Diktiergeräte verfassten automatisch Protokolle von Meetings und Roboter schrieben Finanz- oder Sport-Nachrichten. KI schlich sich unbemerkt in unser Leben ein und veränderte unser Verhalten und unsere Erwartungen.

Was ist künstliche Intelligenz?

Künstliche Intelligenz besteht aus drei Schlüsselkomponenten:

- Statistik und Wahrscheinlichkeitsrechnung,

- Programmieren mit Python,

- und Geschäftsstrategie (z. B. Identifizierung eines Anwendungs- und Geschäftsfalls).

KI übersetzt die Welt um uns herum in Zahlen und mathematische Formeln, damit ein Computer sie verarbeiten kann. Es ist unglaublich, was wir mit Hilfe von Wahrscheinlichkeitsrechnung erreichen und erschaffen können. Denn genau darum geht es beim maschinellen Lernen: Zu berechnen, wie hoch die Wahrscheinlichkeit ist, dass z.B. ein Bild eine Katze oder einen Hund zeigt. Der höchste Prozentsatz gewinnt.

Ein Beispiel dafür wie KI funktioniert, ist der Film iRobot. Will Smith spielt Detective Del Spooner, der in einen Autounfall verwickelt ist, bei dem ein Auto mit zwei Personen darin in einen Fluss stürzt. Ein Roboter springt hinterher, um die Opfer zu retten, zieht aber nur Del Spooner an Land. Ein Mädchen namens Sarah stirbt. Später erklärt Detective Del Spooner:

„Ich war die *logische* Wahl. Die KI errechnete, dass ich eine Überlebenschance von fünfundvierzig Prozent hatte, Sarah nur eine elfprozentige Chance.“

Eine einfache Erklärung dafür, wie KI funktioniert. Und wo der Unterschied zum menschlichen Handeln liegt.

Die statistische Natur der Vorhersage bedeutet, dass alle derzeit in der Praxis eingesetzten ML- und KI-Systeme probabilistisch sind.

Dasselbe Prinzip lässt sich auf Texte anwenden, wenn es darum geht, zu berechnen, welches Wort in einem Satz höchstwahrscheinlich das nächste ist. Heutzutage sogar unter Berücksichtigung von Kontext, Sprache oder Satztyp – wie Fragen vs. Aussagen.

Der Unterschied zwischen KI, maschinellem Lernen und Deep Learning

Wer bereits von KI, maschinellem Lernen (ML) und Deep Learning (DL) gehört hat, weiß vermutlich, dass jedes eine Unterform des anderen ist. Der Unterschied zwischen ML und DL besteht darin, dass ML mehr manuelle Arbeit, aber weniger Daten erfordert. Während DL weniger manuelle Arbeit und mehr Daten (und damit Rechenleistung) erfordert. Je mehr Daten, desto mehr Rechenleistung ist nötig, um sie zu verarbeiten.

Beim maschinellen Lernen wird der Maschine anhand von Beispielen im Voraus mitgeteilt, welche Merkmale eine Katze und welche Merkmale ein Hund hat. Basierend auf dieser Eingabe kann ein mathematisches Modell berechnen, ob ein neues Bild eine Katze oder einen Hund zeigt.

Deep Learning strukturiert Algorithmen in Schichten und schafft ein „künstliches neuronales Netzwerk“, das selbst lernt. Künstliche neuronale Netze, die Deep Learning verwenden, senden die Eingabe (Informationen der Bilder) durch verschiedene Schichten des Netzes und definieren spezifische Merkmale. Nach der Verarbeitung der Daten identifiziert das System selbst die passenden Merkmale, um beispielsweise Hunde oder Katzen zu klassifizieren.

Oder um es einfach zu machen:

KI = Dieser Computer tut etwas Menschliches

ML = Dieser Computer lernt.

DL = Dieser Computer lernt auf eine bestimmte Weise.

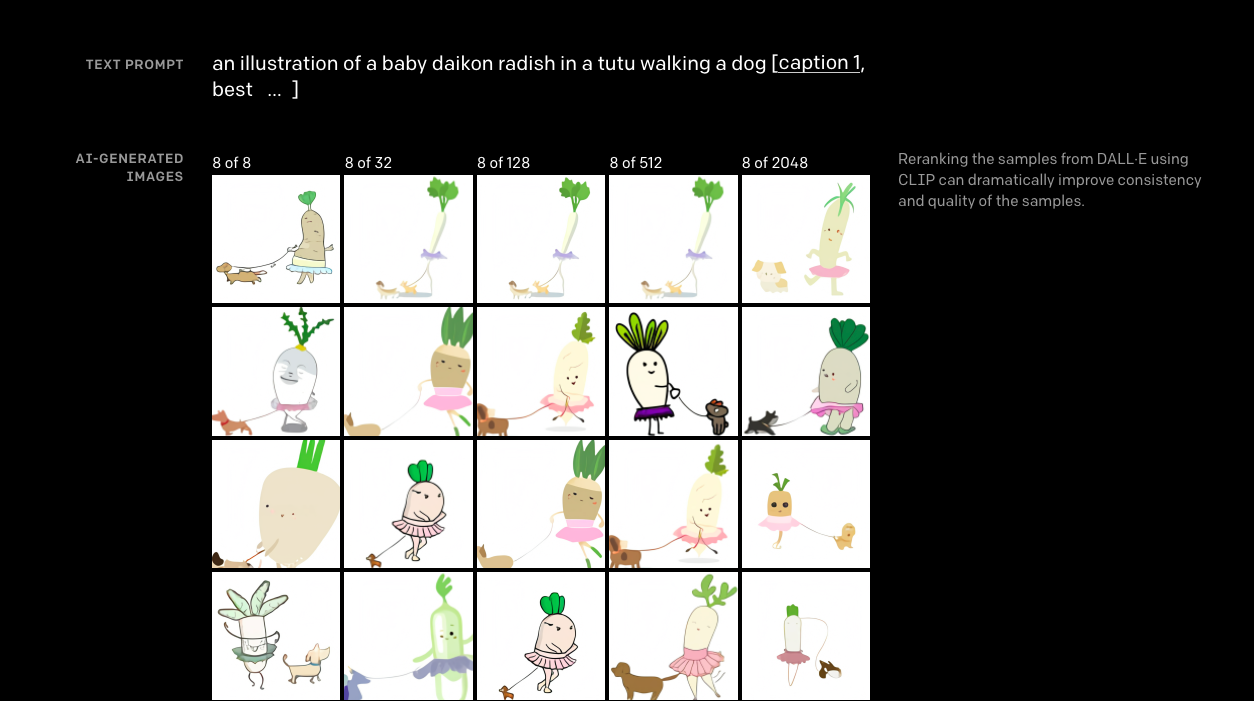

Eine der jüngsten, beeindruckendsten Entwicklungen in diesem Bereich sind große Sprachverarbeitungsmodelle wie GPT-3 oder BERT (Bidirectional Encoder Representation from Transformers), die z.B. Google helfen, Suchanfragen besser zu verstehen. DALL-E ist ein neuronales Netz, das Bilder basierend auf Texteingaben erstellt. Alle drei werden als sogenannte „Transformer-Modelle“ bezeichnet. BERT oder GPT-3 bringen Suchmaschinen, Chatbots, virtuelle Agenten oder maschinelle Übersetzungen auf ein nie dagelegenes Niveau. Sie übertreffen frühere Modelle wie Recurrent Neural Networks (RNNs) oder Gates Recurrent Networks.

Wie Transformers die Content-Welt im Sturm erobern

Transformers haben den Vorteil, dass sie nicht unter einem „Kurzzeitgedächtnis“ leiden. RNNs berücksichtigen z.B. beim Generieren von Text ein kürzeres „Referenzfenster“: Sie sind nicht in der Lage, jeden Aspekt eines längeren Artikels zu berücksichtigen. Sie können beispielsweise nicht auf den ersten Satz zugreifen, während sie versuchen, den 16. zu schreiben. Kontext und wichtige Informationen gehen verloren und darunter leidet die Qualität und Logik. Daher konnten Maschinen bisher lediglich kurze Texte erzeugen. So automatisiert die Nachrichtenagentur Reuters bereits seit 2006 die Erstellung datengetriebener Kurztexte zu Sport, Wetter und Finanzen. Die New York Times, Forbes und viele andere Verlage nutzen seit Jahrzehnten intelligente Content-Technologien. Der Fachbegriff dafür ist automatisierter Journalismus oder robotergenerierte Artikel.

Nun verwenden Transformatoren den sogenannten Aufmerksamkeitsmechanismus, der ein unendliches Referenzfenster hat. Sie können bei der Texterstellung den gesamten Kontext einer Geschichte berücksichtigen. Somit ist die Qualität des generierten Textes höher und der Output umfangreicher.

Durch Transformer-Netzwerke können praktisch beliebige Inhaltsformate erstellt werden. Damit können nicht nur Nachrichten, sondern komplette Langformartikel automatisch generiert werden, wie in Hacker News oder The Guardian zu sehen ist. GPT-3 kann unter anderem auch Texte zusammenfassen, mit Menschen chatten oder Informationen klassifizieren.

Transformer werden anhand extrem großer Datenmengen trainiert. Etwa GPT-n Netzwerke:

- GPT-1: 110 Millionen Parameter, trainiert auf Büchern Corpus-Datensatz mit 7000 unveröffentlichten Büchern.

- GPT-2: 117 Millionen Parameter, trainiert auf einem Datensatz von 8 Millionen Webseiten.

- GPT-3: 175 Milliarden maschinelle Lernparameter, trainiert auf etwa 45 TB Textdaten aus verschiedenen Datensätzen.

- GPT-4: Könnte 100 Billionen Parameter haben und wird „fünfhundertmal“ größer sein als GPT-3.

Wenig beeindruckend: GPT-2s Textvorschläge via https://transformer.huggingface.co/doc/gpt2-large

Vergleicht man GPT-2 mit GPT-3, erkennt man bereits einen deutlichen Qualitätsunterschied. Wir können davon ausgehen, dass GPT-4 das übertreffen wird.

GPT-3 in Aktion ist bereits deutlich schneller und fortgeschrittener via https://beta.openai.com/playground

Diese Erfolge werden durch klare Schwächen überschattet. Wie bereits erwähnt: mehr Daten = mehr benötigte Rechenleistung = mehr Energieverbrauch und damit negativer Einfluss auf das Klima und die Umwelt. Es wird geschätzt, dass das Training eines großen KI-Modells (wie GPT-3) fünfmal mehr kontaminiert als ein Auto in seiner gesamten Lebensdauer – und ihr Nutzen ist nicht so offensichtlich.

M6 – Die Zukunft der Transformatoren?

Am 25. Juni gab die Alibaba DAMO Academy (der Forschungs- und Entwicklungszweig von Alibaba) bekannt, dass sie M6 gebaut haben, ein großes multimodales Multitasking-Sprachmodell mit 1 Billion Parametern – bereits die 5-fache Größe von GPT-3. InfoQ, ein beliebtes chinesisches Tech-Magazin, stellt die wichtigsten Fähigkeiten von M6 zusammen:

„[Es] verfügt über Kognition und Kreativität, die über die traditionelle KI hinausgehen, ist gut im Zeichnen, Schreiben, Fragen und Antworten und hat breite Anwendungsperspektiven in vielen Bereichen wie E-Commerce und Fertigung, Literatur und Kunst.“

Der kritische Aspekt, den die Forscher von Alibaba hervorhoben, war jedoch die signifikante Verbesserung der Effizienz und der Energiekosten. Sie reduzierten den Verbrauch des Modells um 80 % und steigerten seine Effizienz um das 11-fache im Vergleich zu 100-Millionen-Sprachmodellen. Das deutet darauf hin, dass das Aufblasen von Modellen mit Daten und Parametern nicht unbedingt die klügste Lösung ist. Auch hier muss die Effizienz eine Rolle spielen – vor allem wenn man die Kosten für die Umwelt betrachtet.

Was bedeuten diese Entwicklungen für Content-Experten?

Als GPT-3 im Jahr 2020 auf den Markt kam, tauchten eine Reihe von Startups auf, die Inhalte jeglicher Art maschinell erstellten – von Produktinhalten über Werbetexte bis hin zu Bloginhalten. Beinahe alle nutzen GPT-3 als technische Grundlage.

- Jasper – gegründet 2020

- Otherside AI – gegründet 2020

- Writer.com -gegründet 2020

- Copysmith – gegründet 2020

- Writesonic – gegründet 2021

- Rytr.com – gegründet 2021

- ….

Dies zeigt, dass die Automatisierung der Content-Erstellung stärker vorangetrieben wird als jemals zuvor. Computer-generierte Texte haben jedoch Schwächen. So erzeugt GPT-3 „falsche Fakten“ und trifft Aussagen, die nicht korrekt sind oder nicht belegt werden können. Zudem haben maschinell erzeugte Schriftstücke keinen persönlichen Stil oder Ton und sind stilistisch verbesserungswürdig. Das Redigieren von KI-Texten bleibt daher niemandem erspart, der Wert auf Qualität und Glaubwürdigkeit legt.

Die Datengrundlage erlaubt dem Roboterjournalismus nur Informationen zu wiederholen (oder neu zu kombinieren), die bereits im Internet oder Datensatz enthalten ist. Das heißt, Geschichten aus erster Hand gewinnen an Bedeutung und Wert für den Leser. Texte über menschliche Erfahrungen, einzigartiges Wissen oder wahre Neuigkeiten sind daher bis heute unschlagbar. Es wird die Herausforderung (und Mission) der genannten Start-Ups und Tech-Unternehmen sein, an diesen Punkten zu arbeiten.

Es ist wichtig zu berücksichtigen, dass Fortschritte in der Sprachverarbeitung durch KI nicht nur schriftliche Inhalte betreffen, sondern auch sprachliche oder visuelle Inhalte (wie DALL-E zeigt). Damit geht es nicht länger nur um die Textgenerierung, sondern potenziell um ganze künstlich-erstellte Blogs, Magazine oder gar Bücher. Mein Blog etwa verwendet seit kurzem ausschließlich Titelbilder die von DALLE 2 generiert wurden und ersetzt damit übliche Stockfotos.

Ein weiteres Beispiel sind KI-generierte Videos. Das folgende Video wurde vollständig von/mit KI erstellt. Das Drehbuch wurde von ChatGPT geschrieben, die Bilder von DALL-E 2 generiert und das Video dann durch Synthesis.ai automatisch erstellt. Das funktioniert in mehreren Sprachen und für verschiedene Formate, die über Lernvideos hinaus gehen.

Die Fähigkeiten von Deep Learning und maschinellem Lernen zu verstehen, erlaubt uns die Möglichkeiten und Risiken zu sehen, die diese Technologien bieten. Transformer-basierte Sprachverarbeitung kann ein Bestandteil der redaktionellen Arbeit werden und Autoren inspirieren und Starthilfe bei Schreibblockaden bieten. Im Idealfall führt dies zu einer höheren Effizienz und Motivation des Teams. Die steigende Leistungsfähigkeit moderner Netzwerke und deren Kommerzialisierung veranschaulicht jedoch auch, dass Redakteure in absehbarer Zeit mit wachsender Konkurrenz rechnen können.

Bild: DALLE 2

Dieser Artikel hat viele meiner Fragen zum Thema „Wie gut sind künstlich generierte Inhalte durch KI heute“ beantwortet. Ich habe den Artikel sehr gerne gelesen und interessante Ideen daraus schöpfen können. Macht weiter so und schreibt interessante Artikel über KI-Themen.

Danke Sebastian! Es freut mich, dass dir der Artikel geholfen hat.