Benötigte Lesezeit: 7 Minuten

Dein Smartphone verbraucht mehr Energie als dein Kühlschrank. Nicht wegen dem Aufladen des Akkus, sondern wegen dem Datenverkehr den es ermöglicht und erzeugt. Heute hat beinahe jedes Gerät der jüngeren Generation Zugang zum Internet. Vom Staubsauger bis zur Waschmaschine – Daten werden generiert, verarbeitet und zur Beseitigung von Fusseln oder dem Reinigen der Feinwäsche genutzt.

Schon vor Jahren zeigten sich Experten wegen dieser Entwicklung besorgt. So titelte Die Welt bereits im Jahr 2008 “Warum das Internet ein Klimakiller ist” und beklagte in dem entsprechenden Artikel vor allem eins: Kohlendioxidausstoß verursacht durch Datenverarbeitung. Das Problem ist seitdem nicht kleiner geworden.

Daten sind das Blut in den Adern von künstlicher Intelligenz. Die steigende Nachfrage nach intelligenten Technologien, Bestandteil von etwa Smart-Speakern oder Automatisierungssoftware, ließ den Hunger nach Daten exponentiell ansteigen. Heute lautet die Frage nicht mehr nur, ob das Internet ein Klimakiller ist. Sondern welchen Einfluss künstliche Intelligenz auf unsere Umwelt hat.

Was hat künstliche Intelligenz mit dem Klima zu tun?

Pro Information führen Deep Learning Modelle verschiedene mathematische Kalkulationen aus und benötigen dafür viel Rechenleistung. Je größer ein Datensatz, desto mehr Energie wird verbraucht.

Dieser Bedarf steigt beim Trainieren oder Optimieren von neuronalen Netzen. Häufig werden unzählige Versionen eines Modells getestet, bevor eine finale Variante ermittelt werden kann. Ein Prozess, der in Sachen Energiebedarf nur noch durch den Einsatz von KI-Modellen in realen Umgebungen übertroffen wird. Etwa von einem autonomen Fahrzeug, das seine Umwelt analysiert, um sich zu orientieren. Je mehr Parameter ein entsprechendes Modell beinhaltet, desto höher ist der Energiebedarf für solche fortlaufenden Folgerungen.

Schneller und smarter – aber nicht effizienter

Erschwerend kommt hinzu, dass aktuelle Fortschritte im Bereich der künstlichen Intelligenz hauptsächlich durch die Vergrößerung von Datensätzen, Modellen oder der Rechenleistung erzielt werden.

Ein Beispiel ist das (Natural Language Processing) Modell GPT-3 von Open AI, welches Texte automatisch erstellen kann und im Jahr 2020 für sehr viel Aufmerksamkeit sorgte. Die Entwicklung der Vorreiter von GPT-3 verdeutlicht das Problem: Im Jahr 2018 erzielte das BERT-Modell die beste Leistung, nachdem es an einem Datensatz bestehend aus 3 Milliarden Wörtern trainiert wurde. XLNet übertraf BERT mit einem Trainingssatz von 32 Milliarden Wörtern. Kurz danach wurde GPT-2 an einem Datensatz von 40 Milliarden Wörtern trainiert. Ein Datensatz von ungefähr 500 Milliarden Wörtern wurde verwendet, um GPT-3 zu trainieren, was mehrere Tausend Tage dauerte und einen enormen Rechenaufwand benötigte.

Wie viel Kohlendioxid-Ausstoß verursacht ein Sprachmodell?

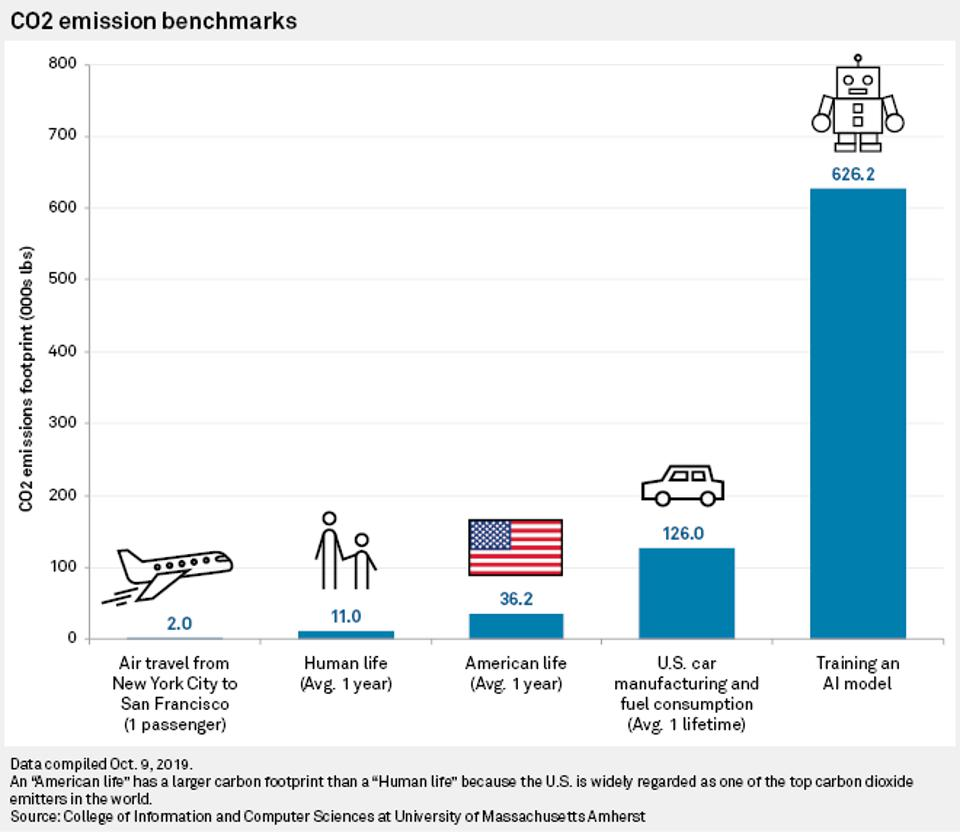

Das Thema beschäftigt zahlreiche Forscher. Ein viel zitierter Beitrag wurde am 5. Juni 2019 von Emma Strubell, Ananya Ganesh und Andrew McCallum veröffentlicht (College of Information and Computer Sciences, University of Massachusetts Amherst). Ihre Ökobilanz: Beim Trainieren mehrerer großer KI-Modelle zur Spracherkennung werden 626.000 Pfund Kohlendioxid ausgestoßen. Dies entspricht fast dem Fünffachen der Lebenszeit-Emissionen eines durchschnittlichen amerikanischen Autos (inklusive der Herstellung des Autos).

BERT hinterlässt einen CO2-Fußabdruck von ungefähr 1.400 Pfund Kohlendioxid, was einem Hin- und Rückflug nach Amerika für eine Person gleicht.

Zu einem ähnlichen Schluss kommt das Allen Institute for AI in Seattle, welches den Einfluss der zunehmenden KI-Forschung auf die Umwelt erforschte. In “The Green AI” wird von einer 300.000-fachen Erhöhung der für Deep-Learning-Experimente erforderlichen Berechnungen gesprochen. Der einfache Grund: Das Thema wurde zwischen 2012 und 2019 immer häufiger untersucht.

David Rolnick, wissenschaftlicher Mitarbeiter an der University of Pennsylvania und Gründer der Climate Change AI, mildert diese Forschungsergebnisse etwas ab. Er weist auf xd.adobe.com darauf hin, dass das Training eines NLP-Modells wesentlich zeit- und energieintensiver als das Training der meisten anderen, kleineren Modelle, die mit einem normalen Laptop durchgeführt werden können.

Ist ein Modell erstmal trainiert und funktioniert, benötigt die eigentliche Nutzung von GPT-3 und Co. lediglich geringe Energieressourcen. Signifikanter Schaden entsteht also vor allem in der initialen Phase. Doch wie genau entsteht der Kohlendioxid-Ausstoß?

Sind Rechenzentren die neuen Kohlekraftwerke?

Server (aus dem Engl. = Diener) sind vereinfacht gesagt, ein Computerprogramm, das Daten speichert und zur Verfügung stellt. Sie “leben” in Rechenzentren und stellen die Grundlage für jede Art von Datenverarbeitung dar. Das bedeutet, jegliche Technologie die auf Datenbewegung und -Verarbeitung beruht, benötigt Server: Je mehr Daten, desto mehr benötigte Server-Leistung, desto mehr Energieverbrauch. Obwohl diese Daten-Fabriken keinen Rauch ausstoßen, sind sie nicht unbedingt umweltfreundlich.

2017 wurden in deutschen Rechenzentren 13,2 Milliarden Kilowattstunden Strom benötigt, was ungefähr dem jährlichen Stromverbrauch Berlins entspricht. Insgesamt ist der Energiebedarf deutscher Rechenzentren in den letzten zehn Jahren um mehr als 25% gestiegen, Tendenz steigend. Der weltweite Stromverbrauch stieg um 70%.

Der Stromverbrauch berührt mindesten zwei klimarelevante Punkte: die Quelle der genutzten Elektrizität und die Produktion von Abwärme (im Englischen = waste heat).

Punkt 1 – die Quelle: Obwohl die Mehrheit der genutzten Energie bisher durch fossile Brennstoffe (Kohle, Öl, Gas) erzeugt wurde, wechseln immer mehr Datenzentren zu grüner Energie (Solar, Windkraft, Wasserkraft).

Punkt 2 – Abwärme: Die Nutzung der Server erzeugt Hitze. Um die Datenzentren nicht zu überhitzen, werden diese gekühlt und das benötigt zusätzliche Energie. In einem durchschnittlichen Rechenzentrum macht eine Standard-Klimaanlage 40% der Energiekosten aus.

Die Verwendung von Kühltürmen, die Wasser verdampfen, um die Luftkühlung anzutreiben, verursacht ein weiteres Umweltproblem: In US-Rechenzentren wurden 2014 schätzungsweise 100 Milliarden Liter Wasser verbraucht. Eine beliebte Lösung besteht daher darin, Rechenzentren einfach in kühlen Gegenden (etwa Skandinavien) zu bauen und die Außenluft in sie zu blasen.

Problem erkannt – Problem gebannt?

Es ist daher verständlich, dass Effizienzsteigerung und die Reduzierung von Emissionen, priorisierte Themen für Betreiber von Rechenzentren sind. Gemessen wird dafür der Parameter (PUE), welcher den Gesamtenergiebedarf von Rechenzentren im Verhältnis zum Energiebedarf der IT-Komponenten angibt. Rechenzentrumsbetreiber streben einen niedrigen PUE-Wert an. Zwischen 2010 und 2017 fiel der durchschnittliche PUE-Wert deutscher Rechenzentren von 1,98 auf 1,75.

Ein PUE von 1,0 wäre eine perfekte Punktzahl.

Bisherige Anstrengungen in dem Bereich führten dazu, dass dem erhöhten Internetverkehr und der Datenlast heute höhere Effizienzsteigerungen entgegenstehen. Unter anderem durch die Schließung älterer Einrichtungen zugunsten hocheffizienter Zentren.

Ein paar Beispiele für Energie-Ziele von großen Tech-Unternehmen:

- Amazon hat das langfristige Ziel, seine globale Infrastruktur mit 100% erneuerbarer Energie zu versorgen. Dies schließt die Cloud-Plattform AWS ein.

- Die DeepMind-Abteilung von Google entwickelte eine KI, die es sich zur Aufgabe macht, den Energieverbrauch zur Kühlung der Rechenzentren von Google zu minimieren. Infolgedessen reduzierte Google den Energiebedarf für Rechenzentren um 35%.

- Microsoft verpflichtete sich, bis 2030 CO2-negativ zu sein. Der Tech-Riese betreibt unter dem Namen Microsoft Azure zum Beispiel massive öffentliche Rechenzentren (Cloud-Angebote)

Innovative Ideen zur Nutzung von Abwärme

Um den negative Einfluss aufs Klima zu reduzieren, werden Prozesse, die Abwärme alternativ einsetzen, immer relevanter. Es gibt inzwischen verschiedene Anwendungsfälle, um Server-generierte Wärme zu nutzen. Zwei Beispiele:

Heizung: Abwärme kann verwendet werden, um Gewächshäuser in kälteren Klimazonen zu heizen und so den Energiebedarf zu senken. Das deutsche Start-Up Windcloud setzte Abwärme ein, um Algen zu züchten (und zu verkaufen). In einem anderen Fall, wird ein Schwimmbad in der Schweiz durch ein nahegelegenes IBM Rechenzentrum beheizt. In Skandinavien ist dies bereits gang und gäbe und senkt sogar den Strompreis für Verbraucher.

Forschung: Das Condorcet-Rechenzentrum in Paris stellt seine Abwärme benachbarten Wissenschaftlern zur Verfügung, welche die Auswirkungen hoher Temperaturen auf die Natur erforschen.

Die Vorteile der künstlichen Intelligenz

Zu guter letzt sollten auch die Potenziale von künstlicher Intelligenz nicht vergessen werden. KI kann Klimavorhersagen stärken, intelligentere Entscheidungen für die Dekarbonisierung von Industrien vom Gebäude bis zum Verkehr ermöglichen und herausfinden, wie erneuerbare Energien zugeteilt werden können.

Die Internationale Energieagentur gibt etwa an, dass bei einer Automatisierung aller Fahrzeuge die Möglichkeit besteht, dass ein reibungsloser Verkehrsfluss und eine einfachere Fahrgemeinschaft den Gesamtenergiebedarf der Transportbranche um 60% senken würden.

Das Projekt „Stena Fuel Pilot“ verwendet etwa KI, um die Versandwege zu optimieren. AI wurde also eingesetzt, um zu berechnen, wie die bestmögliche Strecke mit so wenig Kraftstoff wie möglich zurückgelegt werden kann. So konnten zwei bis drei Prozent der Kraftstoffkosten eingespart werden.

Gebäude, auf die in den letzten 25 Jahren 60% des weltweit steigenden Strombedarfs entfielen, bieten einen enormen Spielraum für Verbesserungen der Energieeffizienz: Intelligentes Heizen und Kühlen, das an Gebäuden-Sensoren und Wetterberichte angeschlossen ist, könnte 10% des Energiebedarfs einsparen.

Wir stehen ganz am Anfang

Trotz dieser positiven Tendenzen besteht viel Nachholbedarf. Insbesondere, wenn man unseren voraussichtlich steigenden Durst nach Daten berücksichtigt. Der schwedische Forscher Anders Andrae prognostiziert, dass Rechenzentren bis 2025 10% des gesamten Stromverbrauchs ausmachen könnten. Führende Wissenschaftler rufen daher Unternehmen und KI-Experten dazu auf, sich mehr mit dem Einfluss von KI auf unser Klima auseinanderzusetzen.

Vorstellbare Maßnahmen sind etwa:

- Die Berechnung der Kohlenstoff-Auswirkungen von KI-Forschung mit dem Emissionsrechner. Sowie der Vergleich verschiedener Modelle und deren Umweltfreundlichkeit vor dem Einsatz.

- Grundlagenforschung zu KI-Formen, die weniger datenhungrig sind als maschinelles Lernen, gezielt zu fördern.

- Die Reduzierung des eigenen Datenverbrauches, etwa durch weniger Netflix-Nutzung.

- Unseren Drang nach Innovation um jeden Preis (Klima?) in Frage zu stellen.

Quellen:

- arxiv.org/abs/1906.02243

- newscientist.com/article/2205779-creating-an-ai-can-be-five-times-worse-for-the-planet-than-a-car/#ixzz6gaoln5O3

- xd.adobe.com/ideas/principles/emerging-technology/ai-impact-on-climate-environment/

- www.forbes.com/sites/robtoews/2020/06/17/deep-learnings-climate-change-problem/?sh=7a4e256c6b43

- www.forbes.com/sites/glenngow/2020/08/21/environmental-sustainability-and-ai/?sh=3d5e16cf7db3

- www.technologyreview.com/2019/06/06/239031/training-a-single-ai-model-can-emit-as-much-carbon-as-five-cars-in-their-lifetimes

- energyeducation.ca/encyclopedia/Waste_heat

- www.nature.com/articles/d41586-018-06610-y

- www.envirosustain.com/2019/07/30/sustainably-digital-waste-heat-recovery-as-the-key-to-green-data-centres/

- horizon-magazine.eu/article/ai-can-help-us-fight-climate-change-it-has-energy-problem-too.html

- www.forbes.com/sites/forbestechcouncil/2020/08/17/why-we-should-care-about-the-environmental-impact-of-ai/?sh=7cfb7ae756ee

- www.windcloud.de/unternehmen/ueber-uns

- en.reset.org/blog/interview-how-can-we-make-ai-more-environmentally-friendly-04022020

- Bild: DALLE 2