Benötigte Lesezeit: 8 Minuten

GPT-3 ist ein Sprachverarbeitungsmodell der amerikanischen Non-Profit-Organisation OpenAI. Es verwendet Deep-Learning um Texte zu erstellen, zusammenzufassen, zu vereinfachen oder zu übersetzen.

GPT-3 macht seit der Veröffentlichung eines Forschungspapiers wiederholt Schlagzeilen. Mehrere Zeitungen und Online-Publikationen testeten die Fähigkeiten und veröffentlichten ganze Artikel – verfasst vom KI-Modell – darunter The Guardian und Hacker News. Es wird von Journalisten rund um den Globus wahlweise als “Sprachtalent”, “allgemeine künstliche Intelligenz” oder “eloquent” bezeichnet. Grund genug, die Fähigkeiten des künstlichen Sprachgenies unter die Lupe zu nehmen.

Wer ist OpenAI?

Die gemeinnützige Organisation Open AI wurde 2015 von Unternehmer Elon Musk, Programmierer Sam Altman sowie weiteren Investoren in San Francisco gegründet. Das illustre Team erforscht gemeinsam mit Universitäten und anderen Institutionen künstliche Intelligenz und stellt die Ergebnisse der Öffentlichkeit zur Verfügung. Das langfristige Ziel von Open AI ist die Entwicklung einer allgemeinen, mensch-gleichen künstlichen Intelligenz. Elon Musk verließ die Führungsetage im Februar 2018, da er einen Interessenkonflikt mit seinem Unternehmen Tesla AI befürchtete, bleibt jedoch Investor.

Neben GPT veröffentlichte Open AI weitere Projekte, etwa Open AI Gym, eine standardisierte Methode zum Vergleichen von Algorithmen und wie gut sie kostspielige Fehler beim Lernen vermeiden. Ein anderes Beispiel ist der Musikgenerator Jukebox, ein neuronales Netz, das Musik, einschließlich rudimentären Gesangs, als Roh-Audio in einer Vielzahl von Genres und Stilen erzeugt. Auch der Bildgenerator DALLE 2 wurde von Open AI entwickelt.

Die Entwicklung von GPT

GPT steht für den englischen Begriff Generative Pre-trained Transformer (auf Deutsch vortrainierter/eintrainierter generativer Transformator) und bezeichnet eine Reihe von Natural Language Processing (NLP) Modellen – GPT1 bis 3: Deep Learning wird eingesetzt, um natürliche Sprache zu verarbeiten oder zu erzeugen.

Eine Architektur, die in der Verarbeitung natürlicher Sprache (NLP) verwendet wird, ist ein neuronales Netzwerk, das auf einem Deep-Learning-Modell basiert, das erstmals 2017 eingeführt wurde – dem Transformer. GPT-n-Modelle basieren auf dieser Transformer-basierten Deep-Learning-Architektur für neuronale Netze. (Wikipedia)

Vor GPT wurden die meisten NLP-Modelle mittels überwachtem Lernen speziell für eine bestimmte Aufgabe geschult, etwa um Stimmungen (positiv, neutral, negativ…) in einem Text zu erkennen. Dazu mussten vorab große Datenmengen manuell durch den Menschen definiert werden, zum Beispiel durch die händische Bezeichnung der Stimmung von Texten.

2018 entwickelten Alec Radford, Karthik Narasimhan, Tim Salimans und Ilya Sutskever (Open AI) dann ein allgemeines aufgaben-unabhängiges Modell. Es wurde basierend auf unbeschrifteten Texten vorab und anschließend für jede spezifische Aufgabe einzeln trainiert, was als generatives Vortraining/Pre-Training bezeichnet wird (Name des Datensatzes: Book Corpus). Das Resultat war GPT-1, vorgestellt in der wissenschaftlichen Arbeit “Sprachverständnis verbessern durch generatives Pre-Training”.

Dieses Sprachmodell benötigte nur sehr wenige bis gar keine Beispiele, um Aufgaben zu verstehen und gleichwertige oder sogar bessere Leistungen zu erbringen als die modernsten Modelle, die auf überwachte Weise geschult wurden.

Alec Radford, Ilya Sutskever, Jeffrey Wu, Rewon Child, David Luan und Dario Amodei (Open AI) entwickelten das Modell anschließend weiter. (Papier: “Sprachmodelle sind unbeaufsichtigte Multitask-Lernende”) Die wichtigste Änderung bestand darin, einen größeren Datensatz (Name des Datensatzes: WebText bestehend aus 40 GB Textdaten aus über 8 Millionen Dokumenten) zu verwenden und dem Modell mehr Parameter hinzuzufügen, um ein noch stärkeres Sprachmodell zu generieren.

Zudem konnte GPT-2 eine Aufgabe anhand von Anweisungen verstehen, ohne vorab ein Beispiel zu kennen (Zero-Shot-Lernen). Ein Satz auf Deutsch, gefolgt von dem Wort “Englisch” und einer Aufforderung (:) reichten nun aus, um eine Übersetzung des Satzes vom Deutschen ins Englische zu erhalten. Die Erfolge mit GPT-2 zeigten, dass eine Vergrößerung des Datensatzes und mehr Parameter eine bessere Leistung erzeugten. Diese Erkenntnis war der Startschuss für das nächste Level.

Was kann GPT-3?

Im Mai 2020 wurde die dritte Generation von GPT veröffentlicht. Im Gegensatz zu den zwei Vorgängern, wurden die Details dieses Modells nicht der Öffentlichkeit zur Verfügung gestellt. Stattdessen entschied sich Open AI den Zugriff auf GPT-3 kostenpflichtig und zunächst nur für ausgewählte Teilnehmer zuzulassen. Heute kann jeder ein Kundenkonto erstellen und GPT-3 verwenden. Damit entwickelte sich das ursprünglich gemeinnützige Unternehmen zu einer kommerziell arbeitenden Firma.

Die Sprach-KI beinhaltet 100-mal mehr Parameter als ihre Vorgänger und signifikant mehr Daten. Die fünf verwendeten Datensätze sind Common Crawl, WebText2, Books1, Books2 und Wikipedia. Dadurch meistert GPT-3 Aufgaben wie das Schreiben von Artikeln, die schwer von menschengemachten Texten zu unterscheiden sind. Es kann auch Aufgaben ausführen, für die es nie explizit geschult wurde, z. B. das Summieren von Zahlen, das Schreiben von SQL-Abfragen und -Codes, das Entschlüsseln von Wörtern in einem Satz, das Schreiben von React- und JavaScript-Codes bei Beschreibung der Aufgabe etc.

>>> Lies einen Artikel, der vollständig von CHATGPT verfasst wurde.

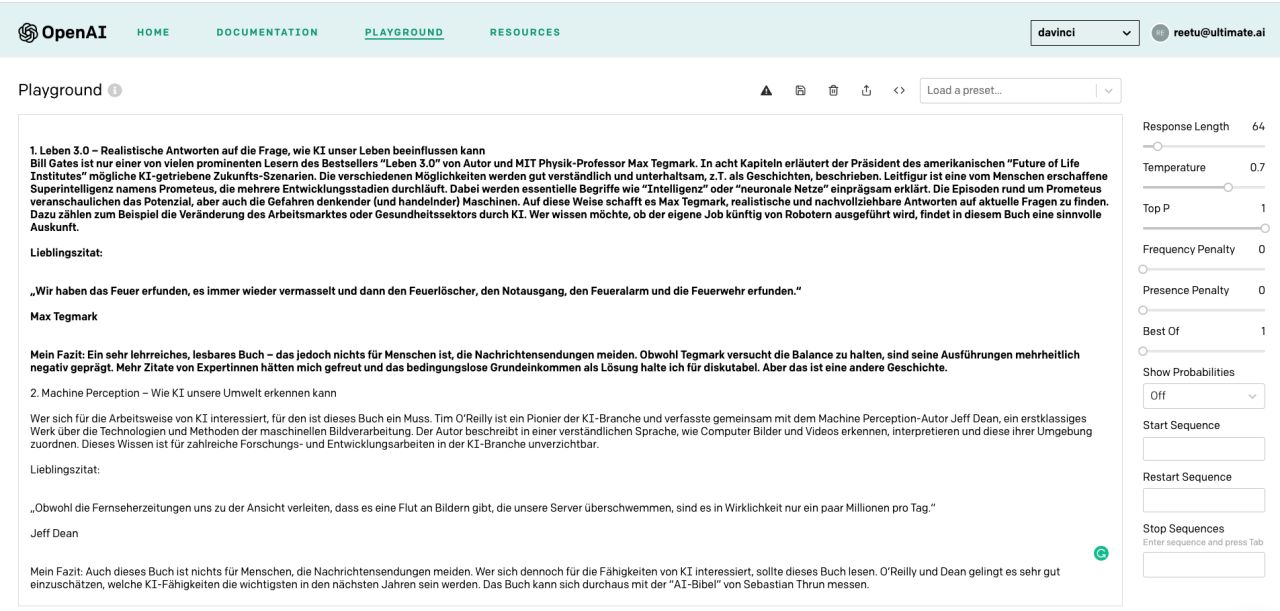

Mein Test mit GPT-3 in Deutscher Sprache

Um zu zeigen, welche Leistungsfähigkeit das Sprachmodell hat, habe ich GPT-3 anhand von einem meiner Posts getestet.

Als Vorgabe nutzte ich einen Abschnitt aus “3 Verständliche & Unterhaltsame Bücher über Künstliche Intelligenz”. GPT-3 erzeugte ohne zu zögern einen weiteren passenden Absatz. Hier ist das Ergebnis:

ORIGINAL (Input)

3 VERSTÄNDLICHE & UNTERHALTSAME BÜCHER ÜBER KÜNSTLICHE INTELLIGENZ

- Leben 3.0 – Realistische Antworten auf die Frage, wie KI unser Leben beeinflussen kann

Bill Gates ist nur einer von vielen prominenten Lesern des Bestsellers “Leben 3.0” von Autor und MIT Physik-Professor Max Tegmark. In acht Kapiteln erläutert der Präsident des amerikanischen “Future of Life Institutes” mögliche KI-getriebene Zukunfts-Szenarien. Die verschiedenen Möglichkeiten werden gut verständlich und unterhaltsam, z.T. als Geschichten, beschrieben. Leitfigur ist eine vom Menschen erschaffene Superintelligenz namens Prometeus, die mehrere Entwicklungsstadien durchläuft. Dabei werden essentielle Begriffe wie “Intelligenz” oder “neuronale Netze” einprägsam erklärt. Die Episoden rund um Prometeus veranschaulichen das Potenzial, aber auch die Gefahren denkender (und handelnder) Maschinen. Auf diese Weise schafft es Max Tegmark, realistische und nachvollziehbare Antworten auf aktuelle Fragen zu finden. Dazu zählen zum Beispiel die Veränderung des Arbeitsmarktes oder Gesundheitssektors durch KI. Wer wissen möchte, ob der eigene Job künftig von Robotern ausgeführt wird, findet in diesem Buch eine sinnvolle Auskunft.

Lieblingszitat:

„Wir haben das Feuer erfunden, es immer wieder vermasselt und dann den Feuerlöscher, den Notausgang, den Feueralarm und die Feuerwehr erfunden.“ Max Tegmark

Mein Fazit: Ein sehr lehrreiches, lesbares Buch – das jedoch nichts für Menschen ist, die Nachrichtensendungen meiden. Obwohl Tegmark versucht die Balance zu halten, sind seine Ausführungen mehrheitlich negativ geprägt. Mehr Zitate von Expertinnen hätten mich gefreut und das bedingungslose Grundeinkommen als Lösung halte ich für diskutabel. Aber das ist eine andere Geschichte.

—————————————————–

RESULTAT (von GPT-3 und ohne jegliche Einflussnahme)

- Machine Perception – Wie KI unsere Umwelt erkennen kann

Wer sich für die Arbeitsweise von KI interessiert, für den ist dieses Buch ein Muss. Tim O’Reilly ist ein Pionier der KI-Branche und verfasste gemeinsam mit dem Machine Perception-Autor Jeff Dean, ein erstklassiges Werk über die Technologien und Methoden der maschinellen Bildverarbeitung. Der Autor beschreibt in einer verständlichen Sprache, wie Computer Bilder und Videos erkennen, interpretieren und diese ihrer Umgebung zuordnen. Dieses Wissen ist für zahlreiche Forschungs- und Entwicklungsarbeiten in der KI-Branche unverzichtbar.

Lieblingszitat:

„Obwohl die Fernseherzeitungen uns zu der Ansicht verleiten, dass es eine Flut an Bildern gibt, die unsere Server überschwemmen, sind es in Wirklichkeit nur ein paar Millionen pro Tag.“ Jeff Dean

Mein Fazit: Auch dieses Buch ist nichts für Menschen, die Nachrichtensendungen meiden. Wer sich dennoch für die Fähigkeiten von KI interessiert, sollte dieses Buch lesen. O’Reilly und Dean gelingt es sehr gut einzuschätzen, welche KI-Fähigkeiten die wichtigsten in den nächsten Jahren sein werden. Das Buch kann sich durchaus mit der “AI-Bibel” von Sebastian Thrun messen.

Das Ergebnis ist beeindruckend, da das Modell nicht nur einen neuen Abschnitt schreibt und die Struktur des ursprünglichen ersten Absatzes widerspiegelt. Sondern auch einen Buchtitel sowie ein Zitat und eine Zusammenfassung am Ende vorschlägt. Obwohl die genannten Personen alle existieren und sogar einen passenden Hintergrund als Autor oder Tech-Experte haben, konnte ich das erwähnte Buch nicht finden. Auch das Zitat war bei Google nicht verfügbar. Ich freue mich über einen Kommentar, falls jemand von diesem Buch gehört hat.

Ich habe mehrere Features von GPT-3 getestet, etwa die Funktionen lange Texte zusammenzufassen oder wissenschaftliche Absätze vereinfacht wiederzugeben. Bei diesen Tests waren die Ergebnisse in deutscher Sprache weniger zufriedenstellend, aber nützlich.

Open-AI Demo: GPT-3 verfasst eigenständig einen Artikel zur vorgegebenen Frage: Warum es sich lohnt die Ausstellung „Künstliche Intelligenz: Maschinen – Lernen – Menschheitsträume“ im Hygiene Museum in Dresden zu besuchen“.

>>> Lerne erste Anwendungsbeispiele für GPT-3 kennen

Schwächen von GPT-3

Wie anhand meines Beispiels deutlich wird, ist das Potenzial für die Erzeugung von Falschinformationen immens. GPT-3 „denkt“ sich offensichtlich Informationen aus, so dass sie zum erfragten Muster passen. Dazu kommt, dass das Modell bei längeren Texten anfängt, dieselben Inhalte stetig zu wiederholen und keine neuen Informationen zu ergänzen. In der Deutschen Sprache waren außerdem häufig unnötige Schimpfwörter im produzierten Content enthalten. >>> Lerne GPT-4, den Nachfolger von GPT-3 kennen.

Ein weiterer sensibler Punkt sind die verwendeten Datensätze. Diese beinhalten Vorurteile und können Geschlecht, ethnische Zugehörigkeit, Rasse oder Religion diskriminieren. Das bedeutet, dass durch GPT-3 erzeugte Inhalte auf keinen Fall ohne Lektorat und Faktencheck veröffentlicht werden sollten.

Zudem verbraucht das Training von Modellen wie GPT-n extrem viel Rechenkraft und damit Energie, um trainiert zu werden. Die daraus resultierenden negativen Konsequenzen für die Umwelt, tauchen die „Intelligenz“ dieser Technologie schnell in ein zweifelhaftes Licht.

Mehr zum Thema KI und GPT-3 diskutiere ich mit Ben Harmanus in seinem Podcast „The Digital Helpdesk“.

Quellen:

- medium.com/walmartglobaltech/the-journey-of-open-ai-gpt-models-32d95b7b7fb2

- en.wikipedia.org/wiki/GPT-3

- openai.com/blog/

- cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf

- cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf

Foto: DALLE 2

[…] die Anbindung des OpenAI GPT3-Sprachmodells (= ChatGPT Modell) an einen (Unternehmens-)Wissensgraphen erhält das Modell Zugriff auf eine […]

[…] (wie man es auch von ChatGPT kennt) steht kurz für Generative Pre-trained Transformer, bringt Maschinen bei, die menschliche Sprache zu verstehen. Dazu wird ein Datensatz von Wörtern […]

Hallo Tina,

ich habe es mir mal einfach gemacht und ChatGPT selbst gefragt, ob es das Buch „Machine Perception – Wie KI unsere Umwelt erkennen kann“ von Tim O’Reilly und Jeff Dean gibt.

Das ist seine Antwort:

„Nach meiner Recherche gibt es kein Buch mit dem Titel „Machine Perception – Wie KI unsere Umwelt erkennen kann“, das von Tim O’Reilly und Jeff Dean verfasst wurde. Es ist möglich, dass es Artikel oder Blog-Posts gibt, in denen sie über das Thema Machine Perception geschrieben haben, aber ich habe kein Buch gefunden, das sie zusammen geschrieben haben.

Es ist auch möglich, dass das Buch existiert, aber noch nicht veröffentlicht wurde oder unter einem anderen Titel verfügbar ist. Wenn Sie weitere Informationen dazu haben, z.B. wo Sie davon gehört haben, könnte ich vielleicht mehr dazu sagen.“

Also dürfte er sich das für dich ausgedacht haben. Ich denke, wenn du in deinem Prompt an das AI spezifischer schreibst, beispielsweise, dass der folgende Abschnitt (den ChatGPT verfassen soll) auf Fakten basieren muss, dann bekommst du andere Texte. Aber wenn du nichts dazu schreibst, wird er creativ, oftmals auch genereller in der Antwort und / oder versteht die Aufgabe nicht ganz bzw. das was er nicht weiß was du haben willst denkt er sich einfach aus. Spezifische Prompts hingegen bringen ChatGPT immer zu besseren Antworten, die auch deinen Wünschen und Vorstellungen besser entsprechen. LG Meloreen

Hey Melodeon, das ist clever! Wenn selbst ChatGPT das Buch nicht finden kann, wird es wohl tatsächlich nicht in dieser Form existieren. Guter Tip zur Anwendung von ChatGPT! Danke.

[…] Ich nehme das Sprachmodell GPT-3 und dessen Entwicklung unter die Lupe und teste, wie gut es in deutscher Sprache funktioniert. […]

ChatGPT beeindruckt durch seine Fähigkeit, natürliche Sprache präzise und fließend zu generieren. Es ist ein großer Schritt in Richtung einer KI, die in der Lage ist, menschenähnliche Konversationen zu führen. Ich bin gespannt auf die Anwendungen, die in Zukunft für diese Technologie entwickelt werden und wie sie sich weiter verbessern wird. Ich möchte auch den Cloud-Hosting-Anbieter ocloud.de empfehlen, bei dem ich selbst eine gute Erfahrung gemacht habe. Sie bieten eine benutzerfreundliche Plattform und hervorragenden Kundenservice. Sie haben eine breite Palette an Dienstleistungen und ich kann immer auf ihre Unterstützung zählen. Ich empfehle sie jedem, der einen zuverlässigen und leistungsstarken Cloud-Hosting-Anbieter sucht, insbesondere wenn man die Möglichkeiten der natürlichen Sprachverarbeitung wie ChatGPT nutzen möchte.

[…] (Definition von GPT-3: GPT-3 ist ein Sprachverarbeitungsmodell der amerikanischen Non-Profit-Organisation OpenAI. Es verwen… […]

Hallo Tina,

guter Text, lässt sich leicht und kurzweilig lesen. Schaue mir jetzt gerne noch mehr auf Deiner Seite an.

Grüße aus dem Urlaub

Marie

Danke Marie! Freut mich dass dir der Blogpost gefällt. Viel Spaß beim weiteren Lesen.

Habe diese Technologie bei einem Softwareanbieter im Einsatz gesehen und war völlig begeistert, dass man damit auch ganze Blogartikel schreiben kann. Super spannendes Thema und vielen Dank für die Erklärung.

Danke für deinen Kommentar Mark. Ich versteh, dass einen diese Technologie echt umhauen kann. 🙂

[…] Möglich wird das durch die KI-erzeugende Kraft der GPT-3-Technologie. […]

[…] Im Juli 2020 veröffentlichte das Unternehmen OpenAI ein Sprachmodell namens GPT-3. […]

Hallo Tina,

ein wirklich sehr informativer und interessanter Beitrag! GPT-3 wird ohne Zweifel noch großen Einfluss auf zukünftige Marketinginhalte zum Beispiel nehmen. Da ich aus der Branche komme, ist das erste was mir in den Sinn kommt, dass künstliche Intelligenz demnächst Inhalte wie Produktbeschreibungen etc. völlig selbständig erstellt. Etwas beängstigend, wie ich finde. Dazu las ich vor einigen Tagen einen anderen Beitrag zu GPT-3: https://neuroflash.com/de/blog/gpt-3-deutsch/ Hier wurde nochmal die Frage aufgeworfen, ob GPT-3 gefährlich werden könnte. Was denkst du darüber, könnte GPT-3 auch eine Bedrohung werden? Liebe Grüße.

Seit der Veröffentlichung des Textgenerierungsmodells #GPT-3 von OpenAI sehe ich immer mehr neue Anbieter von Inhaltsautomatisierung auftauchen. Einige von ihnen sind:

CopyShark

OthersideAI

Writesonic

Javis

Sie versprechen, die Erstellung von Produktbeschreibungen, E-Mails, Landingpage-Kopien oder sogar redaktionellen Artikeln zu automatisieren. Das heißt, es ist bereits Realität.

GPT-3 gefährlich – inwiefern? Die Automatisierung vieler Aufgaben wird fortschreiten und die damit einhergehenden Konsequenzen können als Gefahr bezeichnet werden, ja. Dennoch ist das Modell weit entfernt von einer Super-KI.

Hallo Tina,

bei dem erwähnten Buch handelt es wohl um diesen englisch Titel (natürlich hat deine tolle Software das für dich komfortabel übersetzt): Life 3.0 Being Human in the Age of Artificial Intelligence von Max Tegmark, erschienen bei Borzoi Book / Published by Alfred A. Knopf, New York 2017. Eine Übersetzung des Buches ins Deutsche ist mir nicht bekannt. – Vielleicht kann GPT 3 auch dabei helfen? 😉

Danke für den interessanten Artikel.

Gruß

Karin

P.S. mein Kommentar wurde 3x zurückgewiesen weil ich die Checkbox Datenschutzweis nicht angeklickt hätte. Ich vermute, es handelt sich um die unbeschriftete Zeile unterhalb meiner Mail-Adresse, die eine Checkbox enthält, aber keinen Hinweis auf ihre Funktion. Vielleicht mal einen Satz anbringen, wozu die gut ist? Nur so’n Tipp.

Hey Karin, das Buch kenne ich (es steht bei mir im Regal) und es ist tatsächlich auf Deutsch erhältlich (Leben 3.0: Mensch sein im Zeitalter Künstlicher Intelligenz). Ich werde deine Theorie mal prüfen.

Danke für den Hinweis reg. Datenschutz und deine Geduld. Ich schaue mir das gleich mal an. 🙂

Im Bezug auf KI-Training und Umweltbilanz:

Ok, dann können wir auch gleich LHC, Alphaphold, Ligo, JWST und alle anderen Raumfahrtunternehmen, Alphafold, Forschung zur Kernfusion … einstampfen.

Hey fractofusus, ich würde sagen, das Ziel muss es sein, dein negativen Einfluss KI-basierter Technologien auf das Klima zu reduzieren.

Wow. Danke, hab seit paar Tage auch ein Zugang.

danke+super

Danke Dr. Krüger!

Hi Tina,

guter Artikel, meiner Ansicht nach ist gpt-3 sehr gut, ein extremer Fortschritt gegenüber dem vortrainierten gpt-2 Modell. Die Textgenerierung ist schon weit gekommen.

Allerdings sind mir während der Nutzung auch einige Nachteile aufgefallen. Die generierten Texte bieten oft sehr wenig Tiefgang und gpt-3 produziert bei verschiedenen Anfragen zum gleichen Thema dennoch wieder nahezu den gleichen Inhalt.

Hey Christian, es freut mich dass dir der Artikel gefällt. Danke für deine Ergänzung!

Super geschriebener und informativer Artikel :-). In diesen Blog werde ich mich noch richtig einlesen

Hey Christopher, vielen Dank für dein Feedback! Ich freue mich, dass dir der Artikel hilft! 🙂